인프런 커뮤니티 질문&답변

서버 메모리 문제

23.04.02 16:53 작성

·

414

·

수정됨

답변 5

0

2023. 04. 05. 23:01

선생님, 정말로 감사 드립니다^^

노랑/빨강 경고 메세지가 있어도 실습 진행에는 문제가 없어서 RStudio와 Python 모두 완성했습니다~

그동안 부분적으로 조금씩 알고 있던 지식을 종합해볼 수 있는 좋은 기회를 주셔서 너무나 감사 드리고 좀 더 복습을 통하여 깊이를 더해볼 생각입니다

다시 한번 감사드립니다~꾸벅

0

2023. 04. 05. 18:33

네~ 확인 잘 했습니다.

차근차근 해결해 보죠...^^

이런 문제를 하나씩 해결해 보는 경험이 더~욱 중요 합니다.ㅎ

우선 Server01/02의 디스크 용량을좀 확보해서, 스왑 메모리를 위한 공간을 좀더 확보 해야 할 것 같습니다.

아래 절차대로 진행해 주시고요..

1.Putty로 Server01에 접속 해서 미사용 parcel 파일 삭제

#아래 명령으로 해당파일 삭제하여 2GB 용량 확보

$ rm -rf /opt/cloudera/parcel-repo/CDH-6.3.2-1.cdh6.3.2.p0.1605554-el6.parcel

2.Server01/02에 각각 Putty로 접속해 지난 로그파일 삭제

#Cloudera-scm-server 로그파일 삭제

$ rm -rf /var/log/cloudera-scm-server/*

3.Server02에 접속해 Storm, Redis 등 설치위해 다운로드 됐던 파일들 삭제

$ rm -rf /home/pilot-pjt/redis-5.0.7.tar.gz

$ rm -rf /home/pilot-pjt/apache-storm-1.2.3.tar.gz

$ rm -rf /home/pilot-pjt//zeppelin-0.8.2-bin-all.tgz

$ rm -rf /home/pilot-pjt/apache-mahout-distribution-0.13.0.tar.gz

Hue의 HDFS 브라우져를 실행해, 하둡에 불필요하게 생성한 테스트 파일이 있으면 삭제

1~4번을 진행해 주시고, CM을 재시작해 주세요!!!

CM이 정상적으로 올라 왔으면, 다음으로 HDFS가 Safe 모드로 전환 됐는지 아래 내용으로 점검해 주시고요,

$ hdfs dfsadmin -safemode get

위명령으로 "Safe mode is On" 이면 다음 명령으로 Safe 모드를 Off

$ hdfs dfsadmin -safemode leave

추가로 실환경에선 다음 명령으로 HDFS의 상태를 자주 점검해 봅니다. 요것도 해서 문제가 없는지 한번 살펴봐 주시고요.

$ hdfs fsck /HDFS에 깨진 파일이 있으면 파일럿 환경은 분산모드가 아니라서 복구가 되지 않습니다. 아래 명령으로 corrupt 파일이 있다면 모두 삭제 합니다.

$ hdfs fsck / -delete

이렇게 쭉~~ 진행해 보시면 노랑/빨강 경고 메세지는 좀 줄어들 겁니다. 앞서 말씀 드렸듯이 정지/셧다운 문제만 아니면 실습 진행엔 크게 문제 되진 않을겁니다.

- 빅디 드림

0

2023. 04. 04. 22:55

선생님, 파일럿 프로젝트 후반부로 갈수록 시스템 로그파일이 많아질텐데 로그파일을 삭제하면 안될까요?

그리고 개인적으로 궁금한 것은 임계값 설정에 경고, 심각이 있고, 모두, 안함, 지정 중에서 지정으로 되어 있는데 모두와 안함은 어떤 의미 인가요?

2023. 04. 04. 23:49

아! 죄송해요!! "candyclara"님!

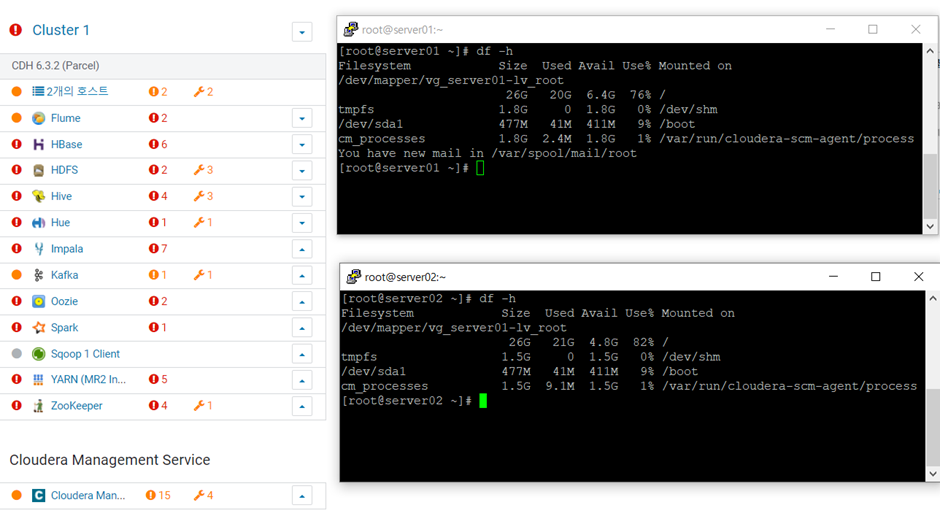

제가 요청 명령문을 잘못 알려 드렸네요..아래 df 명령으로 다시한번 부탁 드립니다.

아래 명령을 실행하면 마운트된 디스크의 사용량을 확인해 보실 수 있습니다. -빅디 드림

$ df -h

0

2023. 04. 03. 18:17

넵! 보내주신 내용 잘 확인했습니다.

내용상으론 클라우데라가 정상 작동하고 있는 것으로 보이는데요..^^;;

CM에서 각종 경고 및 느낌표 아이콘의 경우 디스크/메모리 자원등이 임계치에 가까워져 표기되는 현상으로 파일럿 프로젝트 후반부에선 극히 정상 입니다.

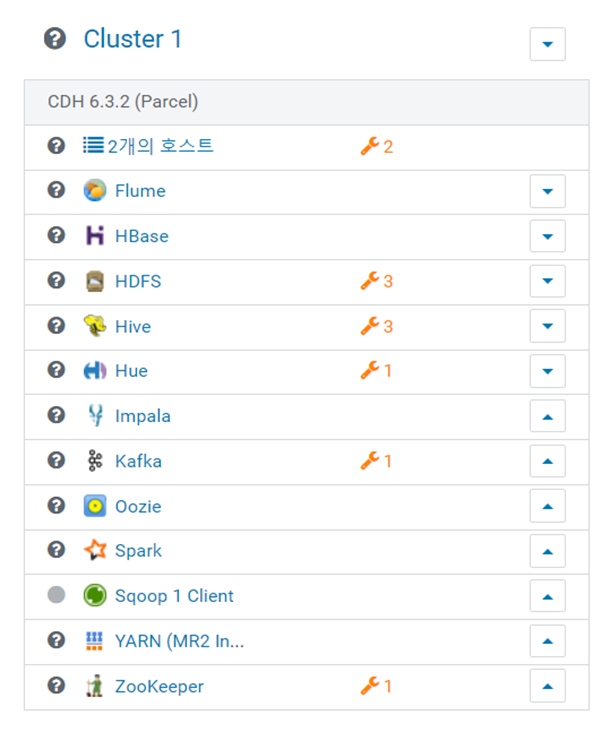

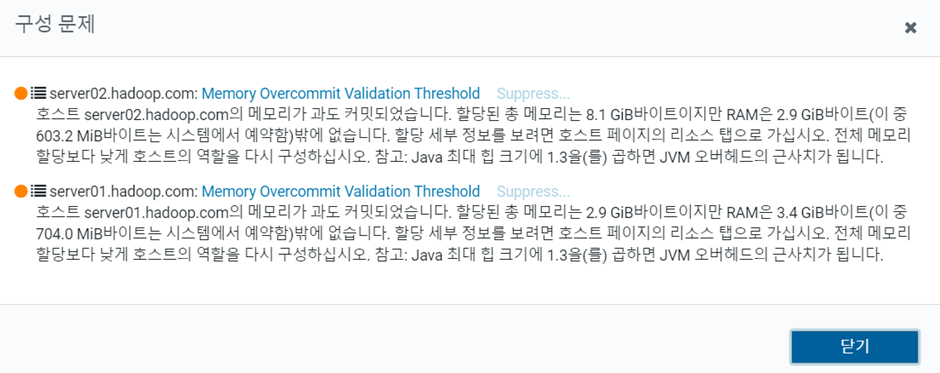

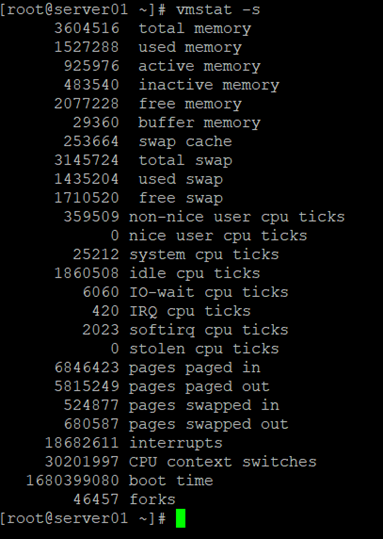

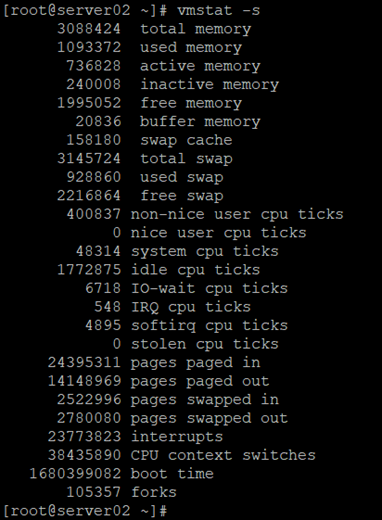

특히 메모리 오버커밋 메세지는 뒤로 갈수로 계속 뜰수 밖에 없는데요...이유는 하둡/HBase/주키퍼/카프카/스파크 등등등을 실행 하는데 물리적 메모리(32GB)로는 턱없이 부족합니다. 그래서 파일럿 프로젝트에선 부족한 메모리를 대신에 디스크를 사용하는 메모리 스왑을 적극적으로 사용하고 SSD급 디스크 공간에 여유가 있어야 실습을 정상적으로 진행 하실 수 있습니다.

이때 디스크 공간은, 윈도우의 파일시스템의 여유 공간이 아니라, 리눅스 로컬디스크의 공간이고, 수강생들마다 파일럿 실습 진행방식에 따라 이 디스크 공간이 후반부로 갈수록 부족해 지는 현상이 나타나고, 메모리 스왑이 되지 않아 실습환경의 소프트웨어들에서 복합적인 문제가 발생하게 됩니다. (참고로 이런 상황은 다양한 테스트를 많이 하시는 우등 수강생일 수록 더 빨리 나타납니다. ^^)

우선 위문제로 추측이 되는데요...

확인을 위해 Server01/02에 Putty로 각각 접속해서 아래 두명령 결과를 부탁드립니다~

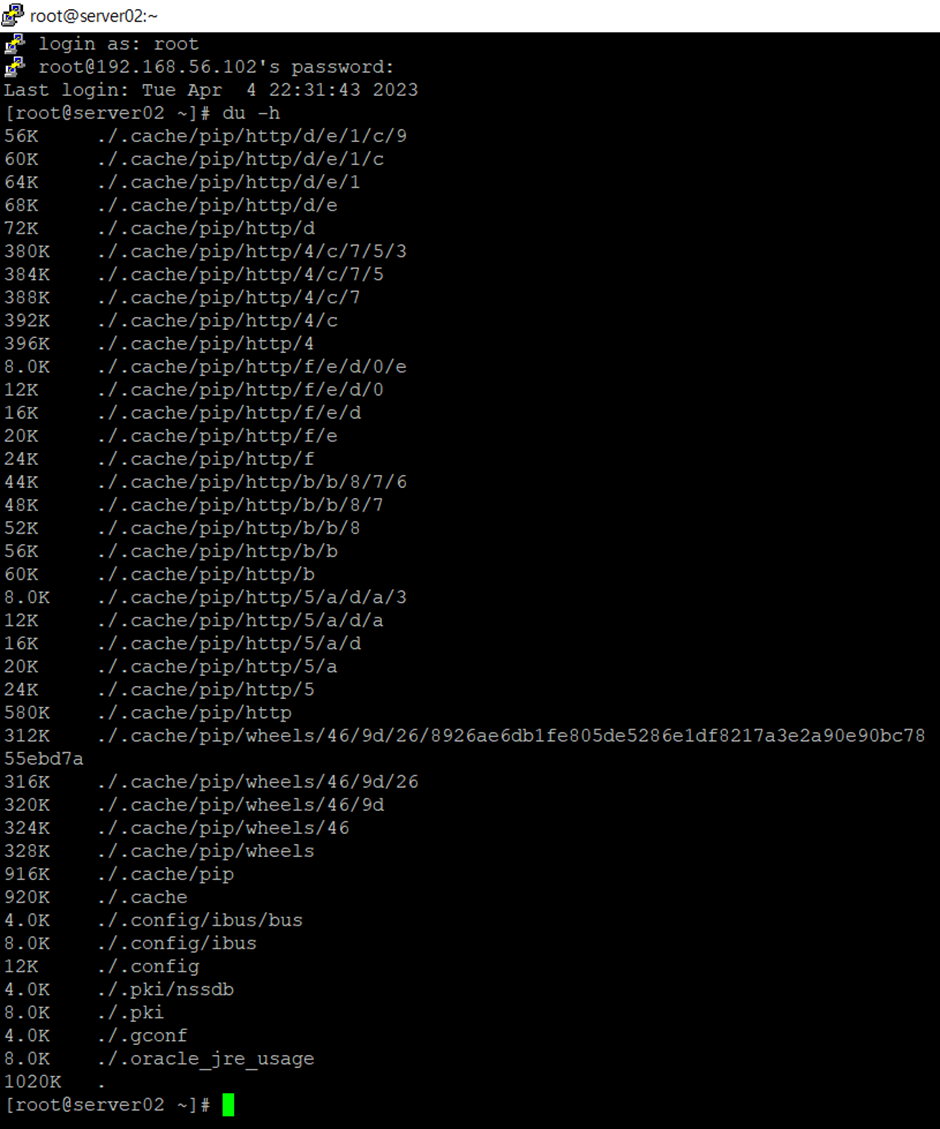

$ du -h

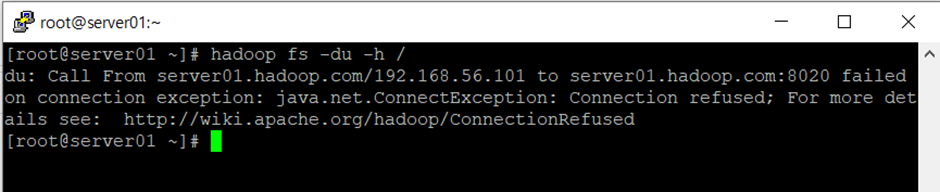

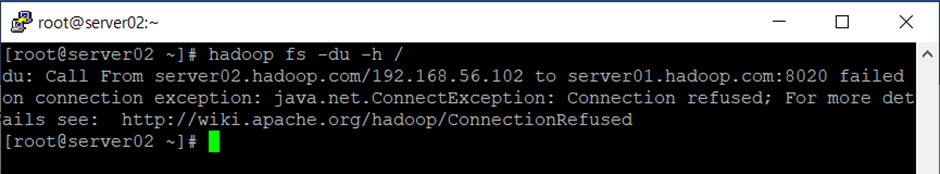

$ hadoop fs -du -h /

-빅디 드림

0

2023. 04. 03. 10:03

안녕하세요! "candyclara"님!

파일럿 프로젝트 완료 직전까지 요셨네요...

고생 많으셨습니다~ ^^

음...보여주신 정보로는 정확히 어떤 문제인지 파악하기 어려운데요...

32G 메모리에 디스크도 여유가 있다면, 리소스 문제로 보이지는 않습니다.

우선 파일럿PC가 빠방하니깐...CM > Home > Cloudera Manager Service를 실행해 모니터링 결과 부탁 드립니다.

-빅디 드림

2023. 04. 06. 09:43

네~ candyclara님!

파일럿 프로젝트 완주 하느라 수고 많으셨습니다!!! ^^