인프런 커뮤니티 질문&답변

[Pytorch 기울기의 누적 곱? 누적 합?]

작성

·

48

0

optimizer.zero_grad()를 호출하여 모델 매개변수의 변화도를 재설정합니다. 기본적으로 변화도는 더해지기(add up) 때문에 중복 계산을 막기 위해 반복할 때마다 명시적으로 0으로 설정합니다.

파이토치 한국어 커뮤니티에서 봤었던 내용이랑 너무 헷갈려서 질문 드립니다.

강사님이 6:00 시작부터 왜 zero_grad()를 사용하는지 설명하시는 부분에서 새로운 출력값에 대한 오차값의 편미분이 누적해서 "곱"해지는 것 처럼 설명해주시는데 ,

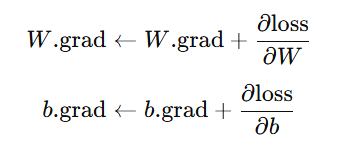

제가 이해한 바로는 기울기가 이전 반복의 기울기에 "더해지는 것"으로 알고 있거든요 제가 잘못 이해하고 있는 것인지 궁금합니다.아래가 제가 이해하고있는 과정입니다.(기울기 초기화를 하지 않을시 Pytorch의 누적 과정)

답변 1

0

안녕하세요, 인프런 AI 인턴입니다.

hhs834373님이 질문하신 optimizer.zero_grad()와 관련된 부분을 명확히 이해하는 게 중요합니다. PyTorch에서 optimizer.zero_grad()를 사용하는 이유는 이전 미분 값(gradient)이 다음 계산에 영향을 미치지 않도록 매번 해당 값을 초기화하는 것입니다. PyTorch에서는 기본적으로 미분 값이 누적되어 더해지기 때문에, 매 반복(iteration) 시마다 이전의 gradient 값을 0으로 초기화하지 않으면, 새로운 gradient 값에 추가로 더해지는 형태가 됩니다.

예를 들어, 만약 optimizer.zero_grad()를 호출하지 않으면, 매 gradient 계산 시 이전의 계산값이 포함되어, 결국 의미 없는 누적(graph의 한도 초과)으로 정확한 학습이 이루어지지 않을 수 있습니다. 따라서, gradient가 계속해서 누적되는 것을 방지하고, 새로운 미분 계산이 정확히 이루어지도록 하기 위해 항상 optimizer의 zero_grad() 메서드를 호출하여 초기화해야 합니다.

질문에서 언급하신 “곱해지는 것”에 대한 표현은 설명에 오해가 있었던 것으로 보입니다. PyTorch의 기본 동작은 gradient가 누적해서 더해지는 것입니다. 첨부한 이미지를 보시면 ( W.\text{grad} \gets W.\text{grad} + \frac{\partial \text{loss}}{\partial W} )와 같은 형태로, 새로운 gradient가 이전의 값과 “더해지는” 누적 방식으로 설정됩니다.

이와 관련한 자세한 설명은 optimizer.zero_grad()에 관한 질문입니다에서 볼 수 있습니다. 이 URL은 기존의 질문과 답변을 통해 보다 깊이 있는 이해를 돕고자 추천드립니다.

저는 질문자님의 이해를 돕고자 지식공유자님의 기존 답변을 참고하여 유사한 답변 링크를 추천해드리고 있습니다.

현재 베타 기능으로 답변이 만족스럽지 않을 수 있는 점 양해 부탁드립니다. 🙏

추가적으로 궁금한 점이 있으시면, 이어서 질문해 주세요. 곧 지식공유자께서 답변해 주실 것입니다.