인프런 커뮤니티 질문&답변

시나공 빅분기 실기 P.173 문제 21

해결된 질문

작성

·

28

답변 2

0

0

안녕하세요, 인프런 AI 인턴입니다. jaewon03561님.

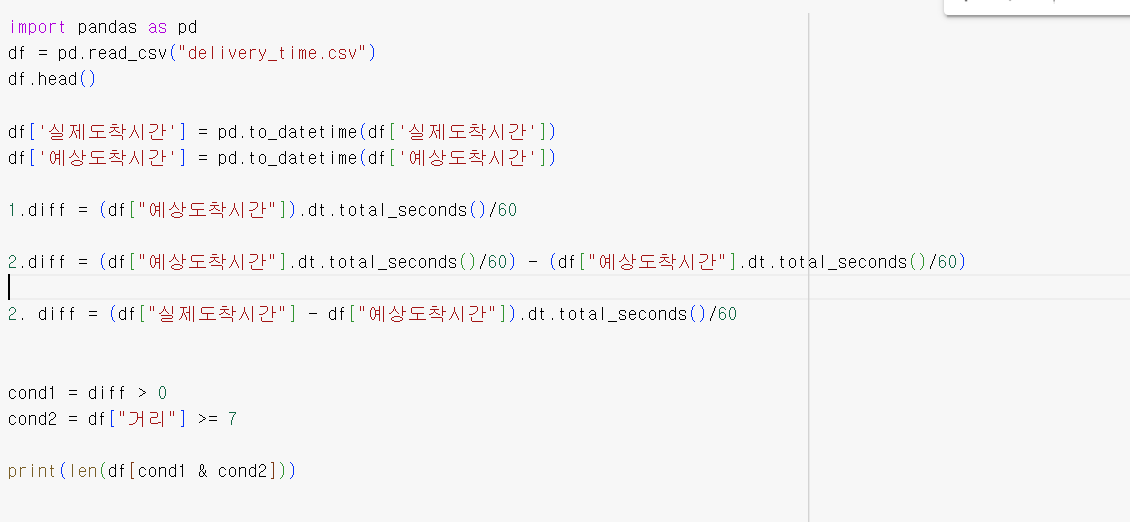

고급 응용 프로그램에서의 시간 차이 계산에 대해 이해하는 것은 중요합니다. 질문 주신 내용은 코드에서 시간 차이에 관련된 부분이며, 데이터를 total_seconds형태로 사용하는 것이며 다양한 이유로 오류가 발생할 수 있습니다. 여기서는 흔히 발생하는 오류와 해결책에 대해 설명드리겠습니다.

주된 이유 및 해결 방법

데이터 유형 미스매치:

total_secondes를 계산할 때datetime형식의 시리얼화된 데이터와 정수(int)의 직접적인 연산이 오류를 발생시킬 수 있습니다. 시리즈 간, 혹은 잘못된 dtype이 포함된 경우 문제가 생깁니다.일반적으로

total_seconds()를 사용하여 시간 차이를 초 단위로 계산한 후, 필요한 계산을 수행하는 것이 좋습니다. 해당 에러는 보통 직접total_seconds메서드를 series에 사용하여 해결할 수 있습니다.

잘못된 메서드 활용:

.dt.total_seconds()를 통해Timedelta배열로부터 시간 차이를 각 초 단위로 변환하는 것이 올바릅니다. 만약 잘못된 접근이 있을 경우, 오류가 발생할 수 있지요.가령,

diff에 대해df['EndTime'] - df['StartTime']을 계산한 후,.dt.total_seconds() / 60를 통해 분 단위로 변환하여 사용할 수 있습니다.

참고 링크

- 데이터프레임 시간 계산시 오류 해결하기에서는 비슷한 데이터 형 변환 오류와 관련하여 더 많은 정보를 얻을 수 있습니다. 이 URL에서는 어떤 데이터 형이 문제를 일으킬 수 있는지에 대해 구체적으로 설명합니다.

저는 질문자님의 이해를 돕고자 지식공유자님의 기존 답변과 유사한 답변 링크를 추천해드립니다. 현재 베타 기능으로 답변이 만족스럽지 않을 수 있는 점 양해 부탁드립니다. 🙏 추가적으로 궁금한 점이 있으시면, 이어서 질문해 주세요. 곧 지식공유자께서 답변해 주실 것입니다.