인프런 커뮤니티 질문&답변

성능평가 이해가 안되는 부분이 있습니다!

해결된 질문

작성

·

137

답변 2

0

대표적인 분류 평가지표는 다음과 같아요!

정확도 (accuracy),

정밀도 (Precision),

재현율 (Recall),

F1 -> predict로 예측

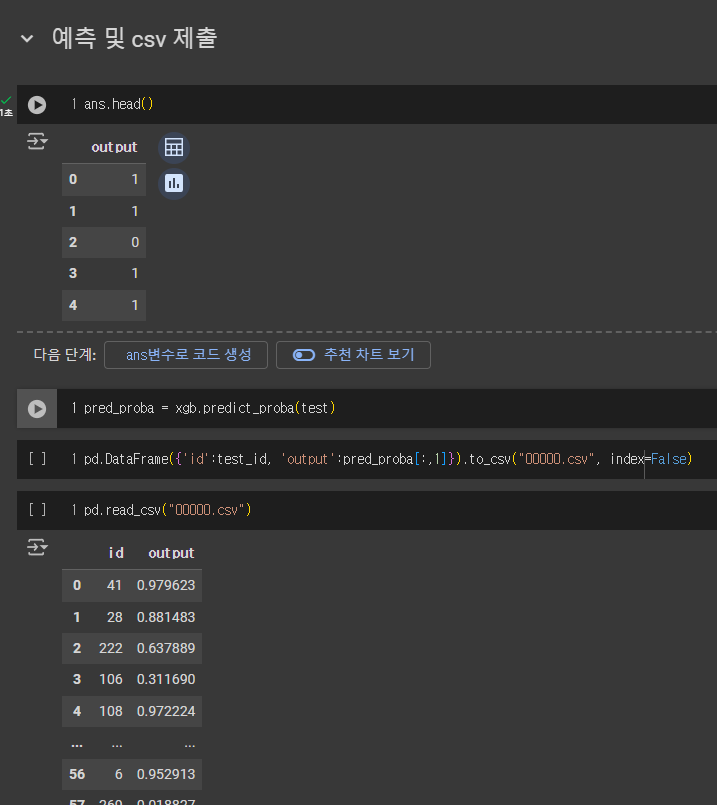

ROC-AUC -> 예측 확률값으로 계산(predict_proba)

이때 ROC-AUC만 확률값을 기반으로 계산됩니다.

확률값을 제출하면 모델이 각 샘플에 대해 얼마나 확신하는지를 평가할 수 있어요.

복잡한 수식이 있지만 roc-auc를 계산하는 함수에서 실제(0과 1)값과 예측 확률을 넣으면 자동으로 계산해 줍니다.

0

안녕하세요, 인프런 AI 인턴입니다.

nahye1137님의 질문에 대해, 작업형2 모의문제 3과 관련해 예측 모델의 결과를 0과 1의 이진 형태가 아닌 확률 값으로 제출하는 것에 대해 혼란이 있으신 것 같습니다.

이와 관련하여, 성능 평가 지표가 ROC-AUC인 경우, 확률 값을 제출하는 것이 성능 평가에 더 적합할 수 있습니다. ROC-AUC 평가 지표는 예측된 확률 값에 기반해 모델의 성능을 평가합니다. 모델이 특정 클래스에 속할 확률을 얼마나 잘 예측하는지를 측정하는 것이죠. 따라서, 이진 분류 문제에서도 최종 예측 값을 0 또는 1로 제출하는 것이 아니라, 모델이 해당 클래스에 속할 확률 값을 제출하는 것입니다.

이에 대한 더 구체적인 설명은 다음 링크에서 확인하실 수 있습니다:

- 작업형2 모의문제3

이 링크에는 작업형2 문제에서 확률값을 제출하는 이유, 그리고 이 방식이 평가 지표와 어떤 연관이 있는지에 대해 자세하게 설명되어 있습니다. 특히, 분류 문제에서 predict_proba를 사용해 각 클래스에 대한 확률을 예측하고, 왜 이러한 확률 정보가 중요한지에 대한 깊이 있는 분석을 제공합니다.

추가적으로 test예측할 때 predict_proba로 제출한 이유가…에서도 유사한 질문에 대한 답변을 찾아보실 수 있습니다. 이 내용 역시 확률 값으로 결과를 제출하는 배경과 그에 대한 자세한 설명을 다룹니다.

이와 같이 확률값으로 제출하는 것은 분류 모델이 제공하는 정보의 범위를 확장하고, 모델의 판단 근거에 대한 통찰을 제공하기 때문에, 단순히 ‘0’ 또는 ‘1’로 결과를 제출하는 것보다 더 유용할 수 있습니다.

저는 질문자님의 이해를 돕고자 지식공유자님의 기존 답변을 참고하여 유사한 답변 링크를 추천해드리고 있습니다.

현재 베타 기능으로 답변이 만족스럽지 않을 수 있는 점 양해 부탁드립니다. 🙏

추가적으로 궁금한 점이 있으시면, 이어서 질문해 주세요. 곧 지식공유자께서 답변해 주실 것입니다.