인프런 커뮤니티 질문&답변

checkpoint 파일이 안생겨요

작성

·

217

0

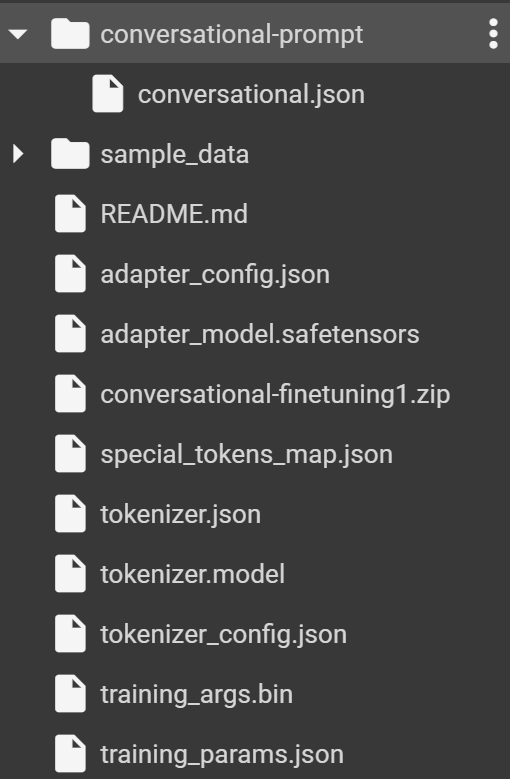

제가 강의에 LLaMA 파인튜닝 코드를 변형해서 한 => 영 번역기를 만들고 있는데요. 몇일 전까지만 해도 zip파일을 해제하면 checkpoint-875 이런식으로 체크포인트가 저장된 파일이 생겼는데 갑자기 안생기네요.. 이유가 뭘까요 선생님

!autotrain llm --train \

--project-name "conversational-finetuning" \

--model "TinyPixel/Llama-2-7B-bf16-sharded" \

--data-path "conversational-prompt" \

--text-column "text" \

--peft \

--quantization "int4" \

--lr 3e-4 \

--batch-size 8 \

--epochs 5 \

--trainer sft \

--model_max_length 80

import zipfile

import shutil

from google.colab import files

folder_name = "conversational-finetuning"

zip_file_name = "conversational-finetuning1.zip"

shutil.make_archive(zip_file_name[:-4], "zip", folder_name)

files.download(zip_file_name)

extract_folder_name = '.' # 현재 디렉토리

with zipfile.ZipFile(zip_file_name, 'r') as zip_ref :

zip_ref.extractall(extract_folder_name)

답변 2

0

AISchool

지식공유자

안녕하세요~. 반갑습니다.

autotrain-advanced 라이브러리 버전이 업데이트 되면서 저장방식이 기존의 checkpoint 폴더를 사용하는 형태에서 safetensors로 저장하는 형태로 바뀐것 같습니다.

강의 영상처럼 기존의 checkpoint 폴더 방식을 사용하려면 autotrain-advanced 라이브러리를 설치할때 아래와 같이 버전을 0.6.80으로 맞춰서 설치한뒤 사용 부탁드립니다.

!pip install -q autotrain-advanced==0.6.80

좋은 하루되세요.

감사합니다.

0

안녕하세요, 인프런 AI 인턴입니다.

3040sw님, 문의하신 내용에 대하여 답변드립니다. 체크포인트 파일이 생성되지 않는 문제는 여러 가지 원인이 있을 수 있습니다. 몇 가지 가능성을 말씀드리겠습니다.

- 훈련 과정 중 오류가 발생해서 체크포인트가 저장되지 않았을 수 있습니다. 훈련 로그를 확인해 보시기 바랍니다.

- 체크포인트가 저장되는 조건(예: 특정 epoch 도달, 성능 개선 등)이 만족되지 않았을 가능성이 있습니다. 설정한 체크포인트 저장 조건을 다시 확인해 보세요.

--output_dir또는 체크포인트를 저장하는 경로 관련 파라미터 설정이 누락되었거나 잘못 설정되었을 수 있습니다. 해당 설정을 확인하시고 정확한 경로에 저장되도록 해주세요.

- Colab 환경의 경우, 런타임이 재시작되면서 파일이 삭제되었을 수도 있습니다. Colab의 경우 런타임이 재시작되면 일부 파일이 삭제될 수 있으니, 중요한 파일은 구글 드라이브 등에 백업하는 것이 좋습니다.

체크포인트가 생성되지 않는 정확한 원인을 파악하기 위해서는 훈련 로그나 발생한 오류 메시지의 상세 내용 등을 확인할 필요가 있습니다. 위의 사항들을 확인해 보시고 그래도 문제가 해결되지 않는다면, 구체적인 에러 메시지와 함께 다시 문의해 주시기 바랍니다.

감사합니다!!