인프런 커뮤니티 질문&답변

tigera-operator 관련 질문 (eviction loop)

작성

·

253

·

수정됨

1

실습에 문제 발생 시 최대한 캡쳐 화면을 꼭 올려 주세요. (원인 파악에 도움이 큽니다)

영상 내용 질문 시 해당 영상 제목과 내용이 있는 시간을 같이 올려주세요. (내용을 다시 들어보고 답변을 드리기 위해서 입니다)

긴 로그는 제 메일로 보내주세요. (k8s.1pro@gmail.com)

카페 [강의 자료실]에도 많은 질문과 답변들이 있어요!

cafe: https://cafe.naver.com/kubeops

kubenetes cluster를 설치하고 있습니다

강사님께서 알려주신 아래 파일과 동일하게 설치하고 있습니다. (master ip만 제 서버에 맞게 설치했습니다)

cat << EOF >> /etc/hosts

192.168.56.30 k8s-master --> 제 ip

EOFhttps://raw.githubusercontent.com/k8s-1pro/install/main/ground/k8s-1.27/vagrant-2.3.4/Vagrantfile

esxi, centos8 3cpu 10GB memory 100GB의 서버에 설치해 수업을 수강 중인 학생입니다.

/tigera-operator tigera-operator-84cf9b6dbb-qnvz9 1/1 Running 0 3mtigera-operator가 문제가 있습니다

가끔 tigera-operator eviction loop 처럼 무한정 pod가 생겨서, 서버 자원을 채워서 메모리와 디스크 부족으로 pod이 생기지 않는데요

아래와 유사하지만 저의 경우

https://github.com/projectcalico/calico/issues/8110

위 tigera-operator가 pod가 무한정 생겼습니다

혹시 이런 경우, 어떻게 대처할 수 있을까요?

이런 문제가 있을 때마다, 그냥 재설치를 하곤 하는데, 정답은 아닌 것 같아 질문드립니다.

아직 쿠버네티스를 잘 몰라서, 이런 문제는 어떻게 대처해야할지 검색해도 잘 모르겠습니다

답변 2

1

loki grafana prometheus를 설치한 후, tigera-operator가 바로 이런 식으로 늘어나게 됩니다...!

loki grafana prometheus를 설치한 후, tigera-operator가 바로 이런 식으로 늘어나게 됩니다...!

직접적인 원인이 loki grafana prometheus인지는 모르겠으나, k8s cluster를 설치한 후, 위 모니터링을 이어서 설치하고 나서, "위와 같이 계속 증식하는 상황을 발견했습니다.

0

안녕하세요.

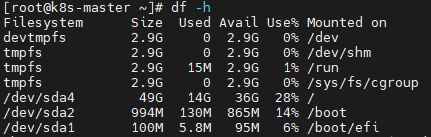

Disk 10기가는 부족합니다. 이건 Vagrant로 Virtualbox에 VM 생성시 기본 디스크 사이즈고요.

모니터링 설치하고 나면 여유 디스크가 별로 없게 되요.

그래서 저도 그런 현상이 많았습니다.

그리고 제 설치 가이드에는 Disk를 넉넉하게 50기가로 줬는데, 제 설치 가이드로 설치한 게 아니신가 보네요?

Vagrantfile을 다운 받아 보시면 Disk 증설 관련 내용이 있습니다.

https://raw.githubusercontent.com/k8s-1pro/install/main/ground/k8s-1.27/vagrant-2.3.4/Vagrantfile

위에 명시해두긴 했는데,

esxi, centos8 3cpu 10GB memory 100GB disk 입니다!

Kubeadm으로 따로 디스크나 메모리 관련해서 할당받는 절차가 필요할까요?