인프런 커뮤니티 질문&답변

크롤링 기사 기간 설정

해결된 질문

작성

·

955

0

안녕하세요

뉴스크롤링에서 크롤링 하고자 하는 뉴스의 기간을 정해주려면

response = requests.get("https://search.naver.com/search.naver?where=news&sm=tab_jum&query=검색어")

위 코드의 " " 안에 뉴스기간을 옵션으로 설정하여

검색한 페이지의 URL을 긁어서 넣어주면 되는걸지요?

감사합니다.

답변 2

1

0

스타트코딩

지식공유자

네 맞습니다~

한개의 예시를 보여드리면

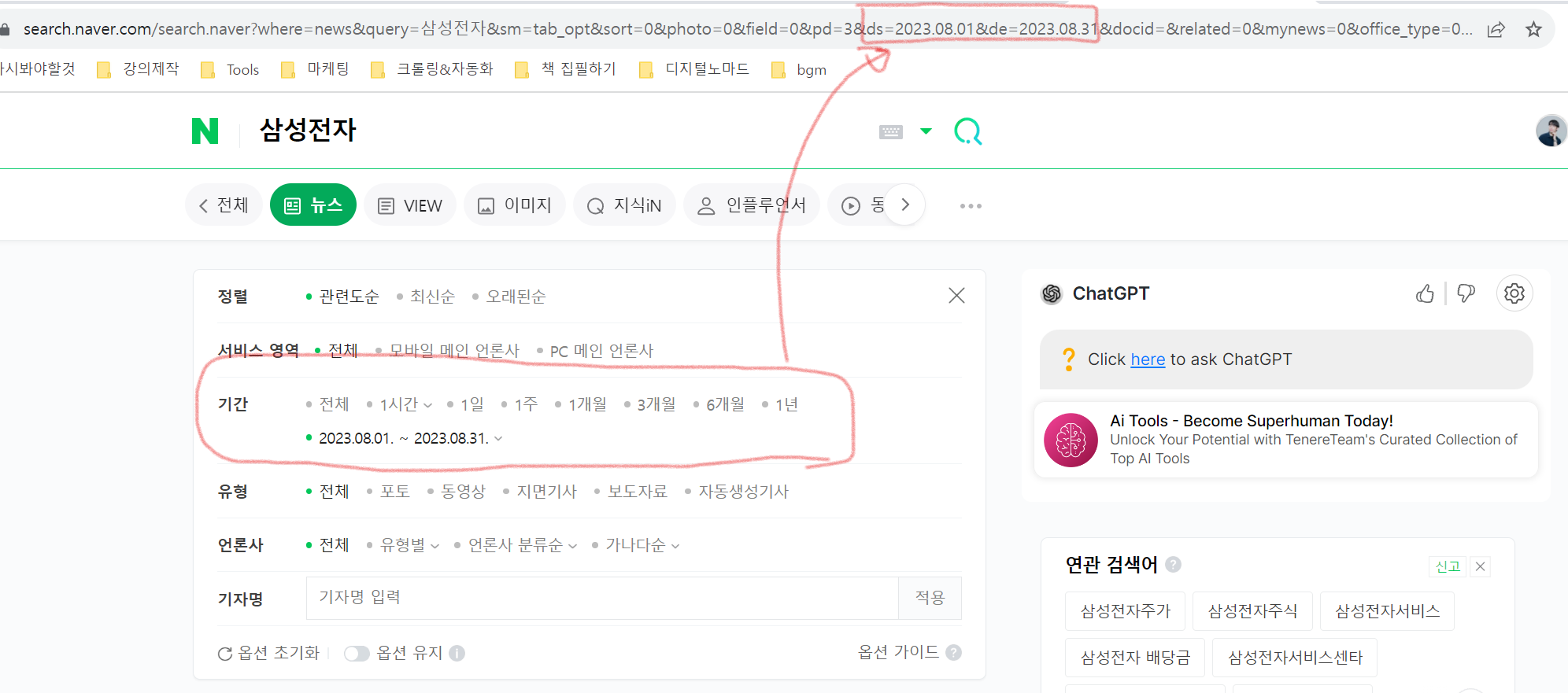

만약 8월 달의 뉴스를 보고 싶으면, 옵션에서 8월1일부터 8월 31일까지 설정 후 적용버튼 클릭

변경된 url을 확인하고 날짜에 관련된 파라미터값을 확인

ds=2023.08.01

de=2023.08.31

이렇게 두개의 파라미터를 추가해주면 됩니다 :)

그럼 즐거운 크롤링 되세요

스타트코딩

지식공유자

response = requests.get(f"https://search.naver.com/search.naver?sm=tab_hty.top&where=news&query={keyword}&start={i}&ds=2023.08.01&de=2023.08.31")이런식으로 파라미터를 수동으로 추가해줄 수 있습니다 ㅎㅎ

키워드나 페이지처리도 그대로 두고요

선생님, 질문하나 더 드리고자 합니다.

위에 말씀해주신 것 처럼 URL만 바꾸면

URL 내에 이미 키워드가 들어가 있습니다 (위의 경우 삼성전자).

이런 경우에는 11.마지막페이지확인하기.py (아래코드)의 코드를 사용할 수 없지 않나요? 11번 강의에는 팝업창으로 검색어와 페이지수를 입력하도록 되어 있는데.. 이런 것은 어떻게 처리하면 되는지요?